Exclusif: Jean-Pierre Marec nous dit tout sur les robots militaires et les soldats augmentés de demain.

Julie Paysant : Pour nos lecteurs qui ne vous connaissent pas encore, pouvez-vous vous présenter ?

Jean-Pierre Marec : Je suis Ingénieur général de l’armement et j’ai fait toute ma carrière à l’ONERA (Office national d’études et de recherches aérospatiales), depuis mon doctorat d’Etat en astrodynamique, jusqu’au poste de Directeur scientifique général et maintenant de Haut conseiller. A l’Académie des technologies, je me suis plus particulièrement intéressé à l’IHM (Interaction homme-machine), puis à la robotique, dans le cadre du groupe de travail « Vers une technologie de la conscience ? », et plus particulièrement à la robotique militaire.

J. P. : Vous soulignez dans le rapport de l’Académie des technologies de 2013 intitulé “Réflexions sur la robotique militaire” que le robot avec une configuration “humaine” n’est pas le moyen optimal pour concevoir des robots destinés à une gamme de tâches données. Comment expliquez-vous que certaines entreprises font le pari du robot militaire humanoïde ?

J.-P. M. : Les roboticiens, comme par exemple Philippe Coiffet ([1]) , qui soutenaient l’idée du robot humanoïde ont été longtemps “combattus”. Ce n’est qu’en 1990, sous l’influence des japonais, que l’idée du robot humanoïde a commencé à prendre corps malgré le désintérêt des américains. Dès 2003, Philippe Coiffet a créé le laboratoire franco-japonais JRL (Joint Robotics Laboratory) à Tsukuba. Actuellement, c’est Abderrahmane Kheddar ([2]) qui le dirige jusqu’à la fin de 2016.

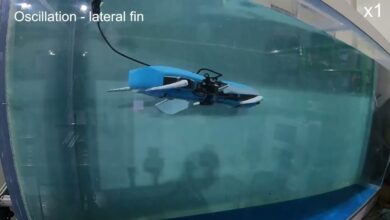

En robotique militaire, le robot humanoïde ne paraîtrait éventuellement utile qu’en robotique terrestre : pourquoi doter un UCAV ou un drone sous-marin d’un pilote robot humanoïde alors qu’un pilote automatique, non humanoïde suffit ?. D’autre part, les bataillons de robots-soldats terrestres semblent actuellement du domaine de la science-fiction. Ils pourraient être utiles pour impressionner l’adversaire ou pour des raisons de polyvalence. Mais d’autres formes semblent mieux adaptées, du moins pour certaines missions, comme les engins chenillés pour le tout-terrain, le robot quadrupède genre « BigDog » pour le transport, le serpent type « Snakebot » pour se faufiler dans des décombres, le géko « Stickybot » ou encore le micro-drone pour l’espionnage.

J. P. : Vous soulignez également que dans un rapport du 19/11/2012 de Human Rights Watch et de la faculté de droits de l’Université de Harvard (Losing Humanity: The Case Against Killer Robots), il est dit que l’utilisation des armes autonomes créerait un vide juridique en matière de responsabilité car il serait difficile d’établir qui serait responsable des actes d’un robot.

Qu’en est-il aujourd’hui de cette réglementation ? Y-a-t-il eu, depuis 2012, des réflexions sur ce “vide juridique”, ou bien, le statut est-il toujours le même ?

J.-P. M. : En ce qui concerne le « vide juridique », je crois utile de faire un petit historique, basé sur les réflexions récentes de Eric Germain ([3]), Jean-Baptiste Vilmer ([4]), Dominique Luzeaux ([5]), Denis Plane ([6]) et Jacques Bongrand ([7]).

Au même titre que pour l’ensemble des armements, l’emploi des robots s’inscrit dans le cadre de l’article 36 du Protocole additionnel I aux Conventions de Genève du 12 août 1949, en date du 8 juin 1977, qui oblige à vérifier que lesdits systèmes d’armes ne sont pas contraires au règles du droit international humanitaire. Tuer, oui, mais sans infliger des souffrances pouvant être considérées comme « excessivement nocives » ou « frappant sans discrimination », notamment les populations civiles.

Il y a une définition plus ou moins consensuelle, qui fait du SALA (Système d’arme létal autonome) un système d’arme qui, une fois activé, permet de sélectionner et de traiter des cibles sans intervention d’un opérateur humain, mais elle n’est pas « juridique ». Les juristes tentent toujours de cerner ce qu’est exactement un SALA , et s’appuient donc sur les experts techniques et opérationnels du domaine : ingénieurs et militaires essentiellement. Leurs éclairages sont ensuite débattus dans des enceintes de discussion comme la Convention sur certaines armes conventionnelles (CCAC, ou CCW en anglais) qui se réunit annuellement à Genève, et où se retrouvent, en plus des experts cités ci-dessus, des représentant d’ONG ainsi que des philosophes ayant pris position sur la question, comme Peter Asaro par exemple.

L’un des points d’achoppement qui empêche l’émergence d’une position commune à l’heure actuelle est la notion d’autonomie, car elle est autrement plus complexe que le triptyque classique « human in/on/out of the loop ([8]) » utilisé aujourd’hui pour caractériser le degré d’autonomie d’un système. A cette difficulté, s’ajoute l’absence de base empirique consistante permettant d’illustrer les effets concrets des SALA. Contrairement aux mines antipersonnel, dont les ravages étaient connus bien avant la Convention d’Ottawa de 1997 (qui prohibe leur utilisation et leur fabrication), il est difficile, voire impossible, de trouver des exemples de « bavures » concrètes susceptibles de permettre d’argumenter. D’où la porte ouverte aux fantasmes excessifs de type « Terminator », qui rend les conditions d’un débat rationnel et apaisé difficiles à réunir . Et les ONG jouent là-dessus.

Nous avons vu que le DIH (Droit international humanitaire) prohibe a priori deux types d’armes : les armes causant des maux superflus (comme les balles explosives, ou dum-dum bullets, qui furent interdites à la fin du XIXe siècle), et les armes non discriminantes : celles dont l’usage ne permet pas la distinction entre combattants et non-combattants, comme les armes de destruction massive. Les ONG s’appuient sur la difficulté pour les SALA de distinguer entre un combattant et un non-combattant pour défendre leur interdiction. Il est vrai que cette distinction est déjà difficile à effectuer par un soldat humain (d’autant plus que des civils peuvent être utilisés comme boucliers humains !). Mais le débat sur la discrimination paraît être un faux débat, car le respect ou non du DIH dépend avant tout du contexte d’emploi de l’arme. Si l’on utilise les SALA que dans des contextes où ils n’auront pas à distinguer un civil d’un combattant, soit parce que toute intrusion est suspecte (comme, par exemple, dans la zone démilitarisée à la frontière entre les deux Corées), soit parce qu’ils sont utilisés dans des milieux où la probabilité de rencontrer des civils est faible, voire nulle (milieu sous-marin ou spatial, par exemple), l’incapacité supposée de distinguer entre un civil et un combattant n’est pas problématique.

Il est d’autre part assez paradoxal que l’on insiste autant sur cette question de discrimination pour les SALA alors que, par exemple, la destruction d’une batterie de missiles par un missile air-sol classique est admise. Si, en revanche, on venait à employer un drone capable de détecter la présence de personnes autour de ladite batterie et de prendre sélectivement lui-même la décision d’engager sa cible ou de s’en abstenir selon qu’il identifie ces personnes à des servants du système ou à des civils, alors il serait qualifié de « robot tueur » par certains ! Un missile air-sol, aveugle ou à la vision déficiente, serait-il donc préférable à un drone autonome doté d’une vision artificielle et d’un traitement d’information lui permettant d’apprécier au mieux la situation, mais capable de se tromper ? Des « bavures » sont toujours possibles, et se pose alors la question de la responsabilité. Qui est responsable ? L’autorité qui a donné l’ordre de ciblage, celle qui a ordonné la mission, l’autorité d’emploi du robot, le maître d’ouvrage en charge de son acquisition, le fabricant, l’architecte du produit, l’investisseur, l’auteur du concept d’emploi du système d’arme létal autonome ? Au-delà de la responsabilité (problème juridique) se pose le problème de la « conscience de tuer », qui est vue comme un garant éthique du « droit de tuer », dans la mesure où en découlent compassion, empathie, répugnance à voir un proche éliminé, jouant un rôle clé en particulier dans l’analyse de la légalité d’un ordre de tuer. En conséquence, certaines ONG militent pour un moratoire sur les robots autonomes létaux.

Historiquement, en 2009 on a commencé à s’inquiéter de la perspective d’autonomisation croissante des systèmes d’armes, notamment pour les drones, afin de supprimer le servant, sujet à des troubles de stress post-traumatiques. C’est l’année de la publication de trois ouvrages américains essentiels qui ont lancé le débat public : il s’agit de « Wired for War » le best-seller de Peter Singer, « Governing Lethal Behavior in Autonomous Robots » de Ron Arkin et « Moral Machines » de Wendell Wallach et Colin Allen.

En septembre 2010, ces auteurs, ainsi que des roboticiens et chercheurs en sciences humaines, ont été réunis autour de l’initiative d’une toute nouvelle ONG, créée en 2009, appelée ICRAC (International Committee for Robot Arms Control), qui a organisé à Berlin une conférence d’experts de trois jours consacrée aux enjeux de l’autonomie de la robotique militaire. L’ICRAC se définit comme une organisation non gouvernementale, composée d’experts en technologies robotiques, questions éthiques, relations et sécurité internationales, droit humanitaire, etc. Depuis mars 2015, on trouve sur leur site internet une liste nominative d’un peu moins de trente membres, dont plus de vingt ressortissants des pays anglo-saxons (principalement Etats-Unis et Royaume Uni), trois allemands, aucun français !

L’été 2010 est un moment clef de la prise de conscience internationale de cet enjeu que l’on qualifiera un peu plus tard d’« autonomie létale » et qui était jusqu’alors présenté comme une fiction lointaine ([9]). Quelques mois avant la rencontre de Berlin, on trouve pour la première fois des articles de presse annonçant l’apparition de véritables « robots-soldats » avec le déploiement expérimental, à la frontière entre les deux Corées, du robot-sentinelle SGR-A1 de la société Samsung-Techwin.([10])

La rencontre de Berlin s’est conclue par le lancement officiel d’une campagne internationale appelant les pays à adopter un moratoire sur le développement des armes robotisées autonomes que l’on n’appelait pas encore SALA (Systèmes d’armes létaux autonomes).

A l’automne 2013, le Ministère de la défense français a soutenu l’initiative diplomatique française d’introduire très officiellement le sujet des SALA dans les discussions des instances internationales du désarmement. C’est bien qu’il considérait que l’inquiétude sur d’éventuelles futures armes totalement autonomes était parfaitement légitime. C’est en effet sous la présidence française de la réunion des États-parties à la Convention de 1980 sur certaines armes classiques (CCAC/CCW) que le sujet des SALA a été ouvert à des discussions d’experts qui se sont déroulées à Genève en mai 2014 et avril 2015.

Dans ce débat prospectif autour d’une arme qui n’existe pas encore, reste à savoir ce que l’on entend précisément quand on parle d’autonomisation des processus décisionnels et des enjeux éthiques qui y sont associés. Le rôle de la réflexion éthique qui est menée en interne “Défense” a précisément pour objet d’éclairer l’autorité politique, afin qu’elle puisse se faire sa propre opinion, forger son propre jugement éthique.

Certaines ONG continuent à militer pour un moratoire sur les robots autonomes létaux. Ainsi, le 28 octobre 2014, le coordinateur de la campagne « Stop killer robots » a délivré une déclaration au Comité sur le désarmement et la sécurité internationale de l’Assemblée générale des Nations unies, pour continuer les réflexions entamées du 13 au 16 mai 2014 sur les systèmes d’armes létaux autonomes dans le cadre des groupes d’experts de la convention sur les armes conventionnelles.

Au-delà de ces ONG, le Parlement européen a adopté, le 27 février 2014, une résolution 2014/2567(RSP) sur l’utilisation des drones armés, et se dit gravement préoccupé par l’utilisation des drones armés en dehors du cadre juridique international. Il demande une information sur les projets de recherche et de développement, ainsi que la mise en place d’un contrôle de la légalité des frappes de drones, avec un droit de recours auprès de l’Union européenne pour les victimes de frappes illégales.

Ainsi, depuis le rapport de 2012 du HRW, le « vide juridique » concernant les SALA se comble-t-il peu à peu. Mais beaucoup reste à faire et il est grand temps de s’en préoccuper.

J. P. : Un autre problème éthique : crainte de voir les opérateurs faire la guerre sans aucune morale, car ils seront éloignés du champ de bataille. Quels exemples concrets vous permettent d’avancer cette crainte ?

J.-P. M. : Je n’ai pas d’exemples concrets mais c’est une crainte partagée par beaucoup, se référant sans doute à la passion mise par certains joueurs de jeux vidéos à exterminer avec frénésie, en toute sécurité et impunément (sauf à faire un mauvais score !), une série de « cibles » (heureusement ici « virtuelles » !).

En revanche, des exemples sont donnés de problèmes psychologiques posés aux opérateurs par l’éloignement du champ de bataille. Loin de faire la guerre sans aucune morale, c’est par une réaction morale- tout à leur honneur- qu’ils développent un sentiment de culpabilité dû à leur éloignement du danger. Comme le rapporte Eric Germain : “En 2010, l’US Air force a décidé de multiplier par cinq le nombre d’aumôniers militaires affectés à la base aérienne de Fort Creech, dans le Nevada, la principale base de drones armés américains. Les pilotes de drones rencontraient alors des problèmes “psychologiques” auxquels le commandement ne souhaitait pas donner une dimension trop médicale, celle par exemple de troubles de stress post-traumatiques ou PTSD.” L’augmentation du nombre d’aumôniers militaires était censée apporter une réponse à la somatisation des interrogations morales des téléopérateurs. Le point de vue des aumôniers est intéressant, car ils ont une vision “positive” de ce stress post-traumatique qui, avant d’être une maladie, représente surtout, à leurs yeux, un signe d’humanité. Il y a des situations proprement insupportables et c’est l’honneur du militaire de ne pas mettre son humanité de côté dans l’accomplissement de sa mission. Il en paye naturellement un prix et la société devrait non seulement reconnaître, mais aussi valoriser, ce type de “blessures invisibles.

Mais, d’un point de vue très trivial, ces blessures sont aussi synonymes de pensions et de prestations sociales qui ont naturellement un coût financier pour la collectivité. À une époque où la politique est dominée par une logique comptable, avant même d’imaginer de valoriser ce qui a un coût, on pense d’abord aux moyens de le supprimer. En 2009-2010, on trouvait parfaitement légitime outre-Atlantique d’écrire dans des documents officiels et publics que la solution la plus pertinente pour résoudre les PTSD des télépilotes de drones armés serait, selon l’expression consacrée, de “faire sortir l’homme de la boucle”. À l’horizon 2025-30, il était ainsi envisagé de concevoir un aéronef sans homme à bord capable de cibler et d’ouvrir le feu sur un ennemi ; cela avec une autonomie totale, c’est-à-dire sans la moindre intervention humaine en dehors de la programmation initiale”. D’où le début de la réflexion sur les SALA (Systèmes d’armes létaux autonomes) et les « robots tueurs ».

J. P. : Avec le soldat augmenté et les robots, comment peut-on envisager le champ de bataille de demain ?

J.-P. M. : Je ferai appel pour cela à l’exposé du 5 novembre 2014 sur « Le champ de bataille du futur », du Général Michel Asencio ([11]), consultant, devant le groupe de travail de l’Académie des technologies « Vers une technologie de la conscience ? ». Il a donné une image futuriste ou de science fiction mais qui dans une vingtaine d’années risque de se rencontrer sur un théâtre régional de moyenne ou de basse intensité. Cela demande de relever certains challenges technologiques dans des domaines particuliers. Dans les trois points clés indiqués figure la « robotisation maximale ».

Elle peut intervenir notamment dans les systèmes spatiaux pour le dépannage ou le ravitaillement automatique en orbite.

Dans l’aviation du futur, il s’agit du travail en essaim des UAV à bas coût, coopérant en patrouilles autonomes, s’insérant dans d’autres systèmes ; des MUAV capables de voler à l’intérieur d’un immeuble, de se percher et d’observer ; de la maîtrise de fomations constituées d’avions pilotés et d’UCAV. Les UAV doivent être de plus grande taille, supersoniques voire hypersoniques.

Pour les systèmes terrestres et le combat en milieu urbain, elle peut être utile pour la détection et l’élimination de bombes rudimentaires lancées sur la route des convois. Les robots terrestres doivent être améliorés dans les domaines de la navigation et de la locomotion (apprentissage, par exemple) pour résoudre la question de la perception de l’environnement. Un effort particulier doit être fait pour la réalisation de transports terrestres autonomes de grande taille pour assurer le soutien et la logistique.

Pour les systèmes maritimes, il faut pousser la robotisation des engins submersibles.

En conclusion, Michel Asencio reconnaît que pour les ruptures technologiques qui s’annoncent, les Etats-Unis sont en pointe et l’Europe plutôt en retard.

J. P. : Quels sont vos plus grands espoirs concernant l’avenir de la robotique militaire ?

J.-P. M. : Mes plus grands espoirs concernant la robotique militaire est qu’elle se développe harmonieusement, de façon bien contrôlée par l’homme, en respectant des principes d’éthique.

Créés essentiellement pour épargner aux humains des risques inutiles, les robots sont particulièrement adaptés aux missions dites « 4D » : Dull (ennuyeuses, répétitives), Dirty (sales), Distant (éloignées de l’opérateur, qui reste à l’abri), Dangerous (dangereuses).

Pour le développement harmonieux, je rappellerai les quelques recommandations faites dans le rapport de l’Académie des technologies :

– Réduire l’imprévisibilité.

– Garder le sens des responsabilités, malgré la facilité d’emploi.

– Maîtriser la situation face à une complexification constante.

– Tenir compte de l’empathie.

Compte tenu des difficultés techniques et sociétales (réactions des ONG, par exemple) rencontrées pour l’introduction des SALA, il est prudent d’en rester encore pour un temps à des robots télé-opérés ou des SALA utilisés dans des cas où la discrimination militaire-civil ne se pose pas, afin de limiter les « bavures ». L’implication de l’opérateur humain doit donc rester importante lors de la mise en oeuvre des robots, en particulier armés, même si le niveau d’assistance automatique peut être accru afin de faciliter la tâche des opérateurs. C’est la dimension morale qui doit décider de la place laissée à l’homme, en particulier dans l’expression et le contrôle de la violence d’Etat.

Quant aux concepts très futuristes de transhumanisme, de robot et/ou d’homme « augmenté » ([12]), ils pourraient certes modifier très profondément notre point de vue sur les SALA. Ce n’est pas parce que la perspective est lointaine qu’il ne faut pas déjà s’en préoccuper.

Propos recueillis par Julie Paysan

Notes:

1- Philippe Coiffet, Directeur de recherche honoraire au CNRS, Membre de l’Académie des technologies.

2- Abderrahmane Kheddar, Directeur de recherche au CNRS, Directeur du JRL (Joint Robotics Laboratory), Japon. Membre de l’Académie des technologies.

3- Eric Germain, chargé de mission « Ethique des nouvelles technologies, faits religieux et questions sociétales » au sein du pôle « Prospective et recherche stratégique », Direction stratégie de défense, prospective et contre prolifération, Direction générale des relations internationales et de la stratégie (DGRIS), 60 boulevard Général Martial Valin, Paris 15, Cedex 75509, Tél. : 09 88 68 59 71. Communication privée de la retranscription de son intervention orale lors de la présentation publique, le 30/09/15, du rapport CGARM/IESF « Evolution technologique et volonté d’utilisation des armements : le cas de futurs robots tueurs ».

4- Jean-Baptiste Jeangène Vilmer, est docteur en science politique et en philosophie, juriste, et chargé de mission « Affaires transversales et sécurité » au CAPS (Centre d’analyse, de prévision et de stratégie) du Ministère des affaires étrangères. « Robots tueurs : quel encadrement juridique ? », Le magazine des ingénieurs de l’armement, n° 105, avril 2015, p. 32-33.

5- Dominique Luzeaux, IGA (Ingénieur général de l’armement), directeur adjoint Plans de la DIRISI, EMA. « Permis de tuer ? Peut-on faire confiance à un robot ? », Ibid., p. 30-31.

6- Denis Plane, IGA, ex Contrôleur général des armées en mission extraordinaire, membre de la Commission de déontologie des militaires, participe à des missions ponctuelles pour le Ministère de la défense. « Ethique de robots : sans limites ». Ibid., p. 26-27

7- Jacques Bongrand, IGA, Conseiller du président de la région Lorraine pour la stratégie économique. « Conception des armes et volonté sociale ». Ibid., p. 28-29.

8- In the loop : l’humain décide et la machine exécute. On the loop : la machine propose et l’humain peut opposer son veto. Out of the loop : la machine est totalement indépendante.

9- Eric Germain, « 2010 : année zéro des guerres robotisée », Revue de la Défense Nationale, n° 740, mai 2011, p. 119-121.

10- Jon Rabiroff, « Machine gun-toting robots deployed on DMZ », Stars and Stripes, 12/07/2010, http://www.stripes.com/news/pacific/korea/machine-gun-toting-robots-deployed-on-dmz-1.110809

11- Général (2S) Michel Asencio, 6 avenue Jean-Jaurès, 92130 Issy les Moulineaux, Tél. : 01 46 44 81 45, Port. : 06 81 18 35 52, Courriel : michelasencio@orange.fr.

12- Philippe Coiffet, « Robot : cerveau ou âme ?». Editions An Li (83 rue Georges Clémenceau, 49150 Baugé en Anjou), ISBN 979 10 961 24008.

.